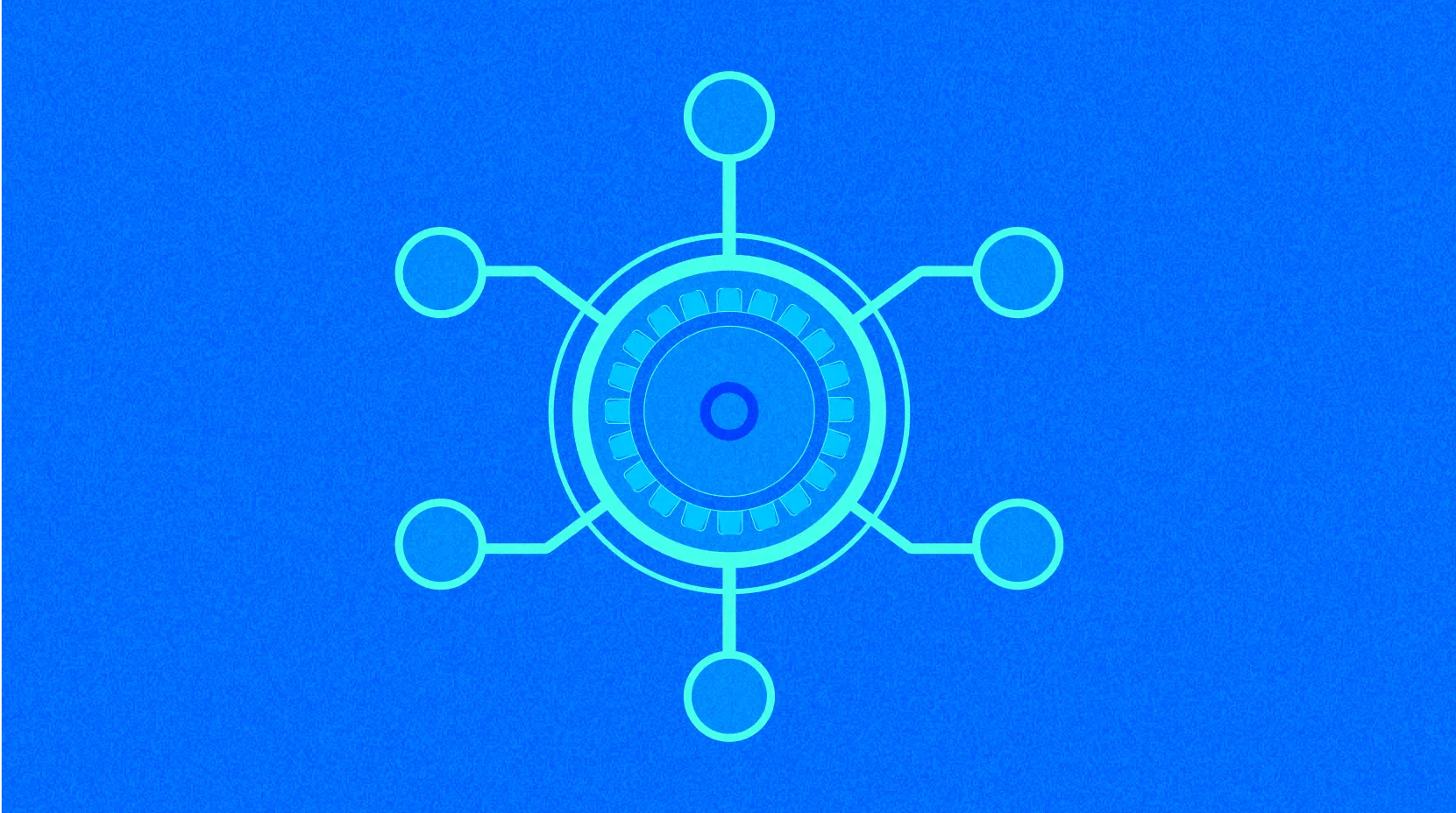

Ecosistema de Computación en Memoria de Apache Spark

La transformación del procesamiento de datos de Spark

Apache Spark traslada la computación del disco a la memoria, acelerando tareas a escala de petabytes decenas de veces más allá de MapReduce. Este ecosistema no solo analiza datos, sino que también integra el aprendizaje automático para la toma de decisiones en tiempo real, convirtiéndose en una plataforma completa para la ciencia de datos.

Amigabilidad para desarrolladores multilingües

Abre soporte para lenguajes como Python y Scala para reducir las barreras entre dominios, consultas estructuradas de Spark SQL, flujos de datos en tiempo real, biblioteca de aprendizaje MLlib, análisis de gráficos GraphX. Este universo modular simplifica la colaboración en equipo y expande los límites de las aplicaciones.

Escalabilidad de una sola máquina a un clúster

Escalado horizontal de una sola máquina a miles de nodos en la nube, con lógica consistente y sin cuellos de botella en el hardware. La arquitectura de memoria reduce la latencia y los costos, permitiendo a las empresas responder rápidamente como una norma en la ingeniería.

Ventajas instantáneas en el sector financiero

En fluctuaciones del mercado de milisegundos, Spark procesa flujos de datos para construir modelos de alta frecuencia para la supervisión de riesgos y la optimización de configuraciones. La toma de decisiones pasa de la experiencia a la evidencia de datos, convirtiéndose en la piedra angular para el análisis del comportamiento de entrenamiento de IA.

La amplitud de aplicación en diversas industrias

La previsión financiera, la minería genética médica, la recomendación en el comercio minorista y la ingeniería de características científicas dependen de la tubería estandarizada de Spark. Esta infraestructura conecta la generación de datos, el procesamiento y los conocimientos a lo largo de toda la cadena.

Resumen

Apache Spark, con su módulo de memoria y extensión multilenguaje, redefine la base de la inteligencia de datos, desde Spark SQL MLlib hasta aplicaciones de IA en finanzas y salud impulsadas por clústeres en la nube. La evolución del espíritu de código abierto transforma el motor de computación en una capa inteligente, conectando el núcleo del crecimiento futuro en la cadena de valor.

Nota de encuesta: Análisis detallado de la mejor inteligencia artificial en 2025

¿Cuál es el mejor Cripto IA en 2025?

¿Cuál es el Mejor AI Ahora?

¿Cómo se compara la capitalización de mercado de Solidus Ai Tech con otras criptomonedas de inteligencia artificial?

¿Por qué ChatGPT es probablemente el mejor IA ahora?

MomoAI: Revolución de Juegos Sociales Potenciada por IA en Solana

Predicción del precio de CTC en 2025: análisis experto y previsión de mercado para el próximo año

Predicción del precio de GUSD en 2025: análisis experto y pronóstico de mercado para el rendimiento futuro de Gemini Dollar